(略读)

摘要

- 基于Transformer的预训练语言模型(如 BERT)在语义句子匹配方面取得了显著的成果。然而,现有模型仍存在捕捉细微差别能力不足的问题。句子的增删和修改等细微噪声可能会导致预测结果的翻转。为了缓解这一问题,提出了一种新颖的双注意力增强 BERT(DABERT),以增强 BERT 捕捉句对细微差别的能力。

- DABERT 包括:

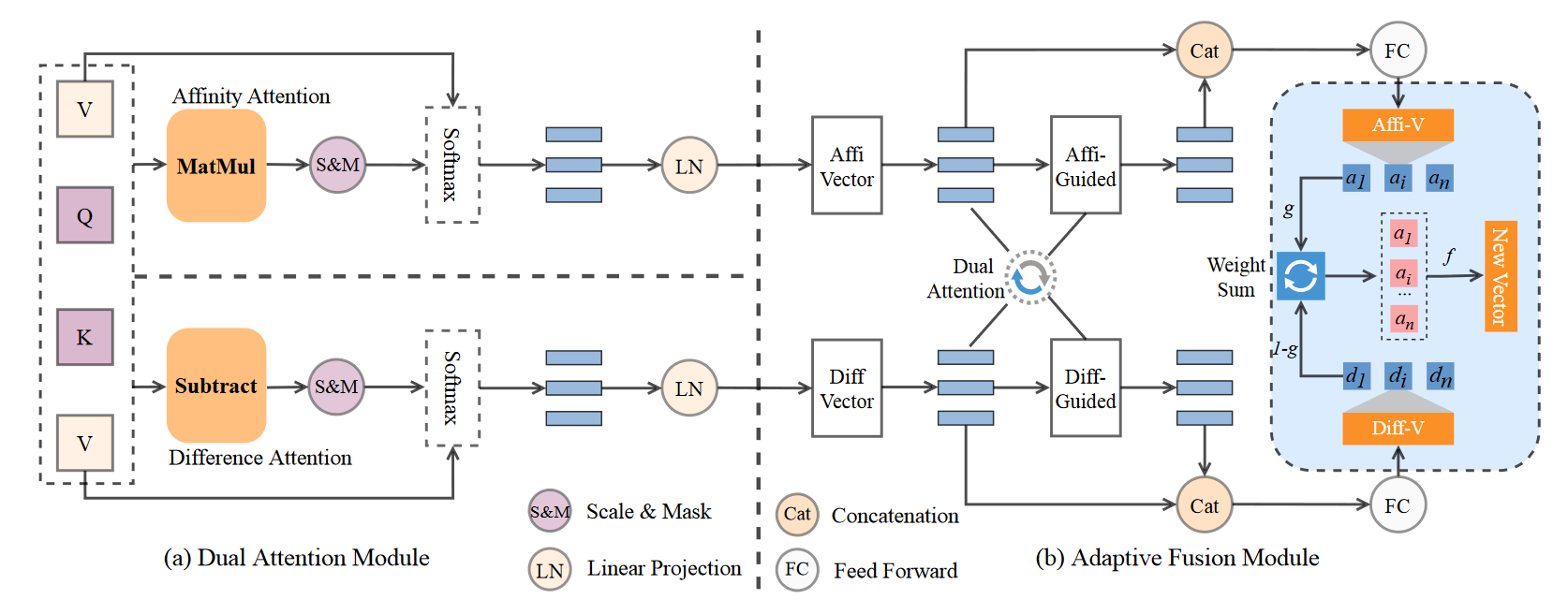

(1)双注意模块Dual Attention,该模块通过引入新的双通道对齐机制来模拟亲和性和差异注意,从而测量软单词匹配。

(2)自适应融合模块,该模块利用注意力学习 affinity 和 difference 特征的聚合,并生成描述句对匹配细节的向量。最终在经过充分研究的语义匹配和鲁棒性测试数据集上进行了大量实验,实验结果表明了我们提出的方法的有效性。

贡献(三方面)

- 作者指出,对句子对之间的细粒度差异语义进行明确建模可以有效地有利于句子语义匹配任务,我们还提出了一种基于 BERT 的新型双通道注意力增强机制。

- 作者提出的 DABERT 模型使用双通道注意力分别关注句子对中的亲和性和差异性特征,并采用软集成调节机制自适应地聚合这两种特征。因此,生成的向量能更好地描述句对的匹配细节。

- 为了验证 DABERT 的有效性,作者在 10 个语义匹配数据集和几个数据噪声数据集上进行了实验,以测试模型的鲁棒性。结果表明,与纯 BERT 相比,DABERT 的绝对值提高了 2% 以上,并且优于其他采用更先进技术和使用外部数据的基于 BERT 的模型。