Explicitly Capturing Relations between Entity Mentions via Graph Neural Networks for Domain-specific Named Entity Recognition

题目:《通过图神经网络显式地捕获实体项之间的关系,用于特定领域命名实体识别》

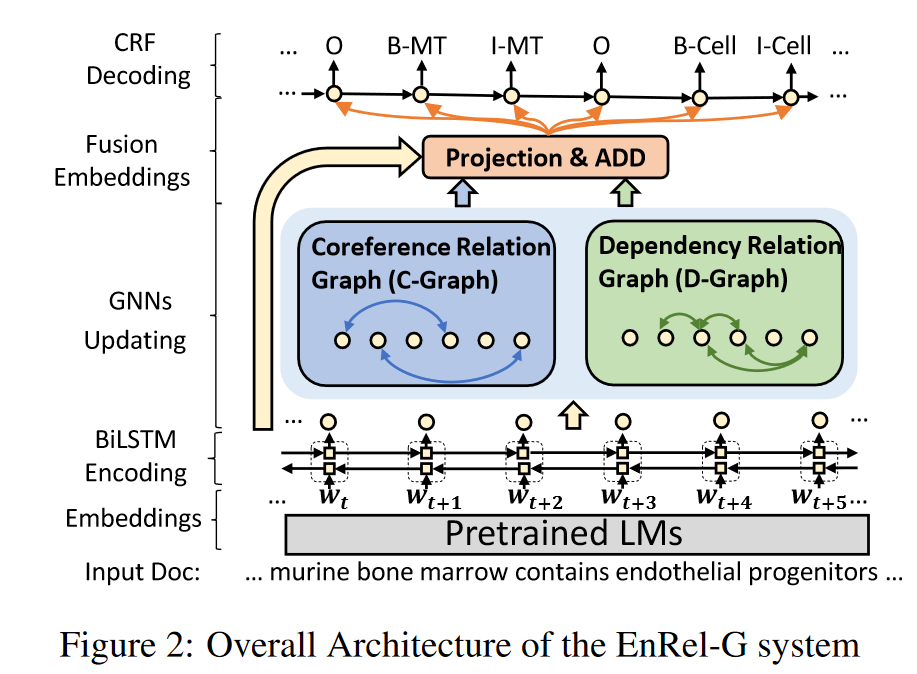

使用图注意力网络:(首先将同一个实体的重复提及连接起来,将文档中反复出现的提及连接起来,既可以整合上下文线索,也可以对其实体类型进行一致的预测;然后基于句子级别的依存关系连接实体指称,以有效识别语义相关的实体。针对标注不足的情况,通过制定一个学习曲线,确定在有限的标注可用的情况下使用该轻量级方法学习到特征。)

方法概述

框架主要包含5层:嵌入层、编码层、GNNs层、融合层和解码层

Embedding Layer

- 选择基于BERT的LM作为嵌入层。对于特定领域的数据集,使用BioBERT 用于生物医学领域,SciBERT用于行星科学领域

- 对一个文档:D=[w1, w2, … , wn] (n个词):BERT输出一个上下文词嵌入矩阵E=[w1, w2, … , wn]

Encoding Layer

BiLSTM对BERT的词嵌入进行编码,将前向和后向LSTM隐藏状态concate为编码表示,为每个词获得一个d2维向量的嵌入矩阵

Graph Neural Networks Layer

利用实体间的全局共指关系(共指图, C -图)和局部依赖关系(依赖图, D-图)构建实体关系图,然后GNN将它们融入到单词表示中。